Wprowadzenie do hybrydowych potoków CPU/GPU

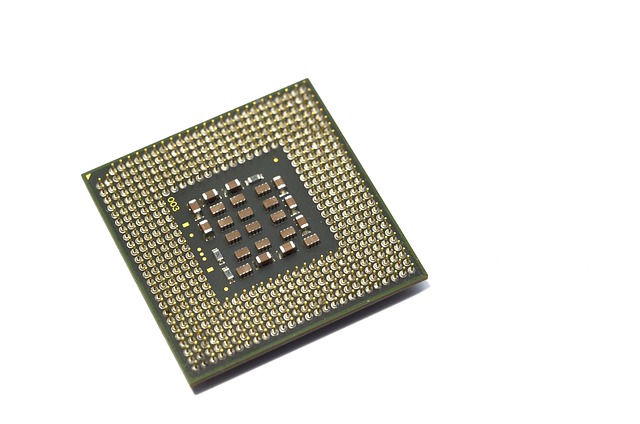

W dzisiejszym świecie technologii obliczeniowej, hybrydowe potoki łączące procesory CPU i GPU stają się coraz bardziej powszechne. Dzięki swoim unikalnym właściwościom, takie jak równoległe przetwarzanie danych oraz przyspieszenie obliczeń graficznych, te architektury pozwalają na osiągnięcie znacznych wzrostów wydajności w aplikacjach wymagających intensywnych obliczeń. Niemniej jednak, złożoność interakcji między CPU a GPU wprowadza nowe wyzwania, zwłaszcza w kontekście obciążeń generowanych przez asynchroniczne operacje Direct Memory Access (DMA).

Asynchroniczne operacje DMA, które umożliwiają GPU dostęp do pamięci bez angażowania CPU, mogą prowadzić do zakłóceń w działaniu procesora centralnego. W szczególności, podczas wykonywania krytycznych zadań na CPU, te zakłócenia mogą skutkować nieprzewidywalnym spadkiem wydajności. Dlatego kluczowe staje się precyzyjne profilowanie obciążenia procesorów oraz identyfikacja i minimalizacja tych zakłóceń, aby zapewnić płynność działania aplikacji.

Mechanizmy działania asynchronicznych operacji DMA

Zanim przejdziemy do analizy zakłóceń, warto zrozumieć, jak działają asynchroniczne operacje DMA. DMA to technologia, która pozwala na przesyłanie danych między pamięcią a urządzeniami peryferyjnymi, takimi jak GPU, bez konieczności angażowania CPU. Dzięki temu CPU może skoncentrować się na innych zadaniach, co teoretycznie powinno zwiększać ogólną wydajność systemu.

Kiedy GPU inicjuje operację DMA, system operacyjny tworzy połączenie między pamięcią a GPU. Operacje te są wykonywane asynchronicznie, co oznacza, że CPU nie czeka na transferu danych i może równocześnie realizować inne instrukcje. Mimo to, proces ten może generować znaczne obciążenie dla magistrali pamięci i systemu, co prowadzi do ryzyka zakłóceń, zwłaszcza gdy CPU próbuje uzyskać dostęp do pamięci w tym samym czasie.

Przykład takiej sytuacji można zaobserwować w grach komputerowych, gdzie GPU renderuje obrazy, a CPU przetwarza logikę gry. Gdy GPU wysyła dane do pamięci, CPU może napotkać opóźnienia, próbując uzyskać dostęp do tych samych zasobów.

Identyfikacja zakłóceń międzyprocesorowych

Identyfikacja zakłóceń wywołanych przez operacje DMA jest kluczowym krokiem w procesie optymalizacji wydajności. W pierwszej kolejności, warto zastosować narzędzia do monitorowania obciążenia CPU i GPU, które mogą dostarczyć cennych informacji na temat ich współdziałania. Narzędzia te pozwalają na analizę czasów oczekiwania, przeciążeń oraz monitorowanie wykorzystania pamięci.

Analizując dane, można zauważyć, że występują okresy, w których CPU jest zmuszone czekać na dane z pamięci, co może prowadzić do spadków wydajności. Warto również zwrócić uwagę na czasy, w jakich wykonywane są operacje DMA, ponieważ mogą one różnić się w zależności od obciążenia systemu. Dobrą praktyką jest również wykonywanie testów z różnymi obciążeniami, aby zrozumieć, w jakich scenariuszach występują największe zakłócenia.

Innym istotnym aspektem jest analiza komunikacji między CPU a GPU. Użycie profilerów, takich jak NVIDIA Nsight lub AMD Radeon GPU Profiler, może dostarczyć informacji na temat wydajności transferów danych oraz zidentyfikować wąskie gardła w komunikacji pomiędzy procesorami.

Techniki minimalizacji zakłóceń w hybrydowych potokach

Po zidentyfikowaniu źródeł zakłóceń, kluczowe staje się zastosowanie technik, które pozwolą na ich minimalizację. Jednym z podejść jest optymalizacja kolejności operacji. Przykładowo, można zorganizować zadania w taki sposób, aby CPU wykonywał operacje nieskracające się czasowo, gdy GPU intensywnie korzysta z pamięci. W ten sposób można zredukować czas oczekiwania CPU na dostęp do danych.

Inną skuteczną metodą jest stosowanie technik buforowania. Umożliwia to przechowywanie danych w pamięci podręcznej, co zmniejsza potrzebę częstych transferów danych pomiędzy CPU a GPU. W praktyce może to wyglądać tak, że CPU najpierw przetwarza dane w swoim buforze, a dopiero później przesyła je do GPU, co pozwala na zminimalizowanie zakłóceń.

Warto również rozważyć stosowanie algorytmów harmonogramowania zadań, które uwzględniają obciążenie zarówno CPU, jak i GPU. Umożliwia to lepsze zarządzanie zasobami systemowymi i redukcję ryzyka wystąpienia zakłóceń. Dzięki odpowiedniemu harmonogramowi można osiągnąć równowagę w obciążeniu obu procesorów, co prowadzi do poprawy wydajności.

Przykłady zastosowań w praktyce

Rozważając techniki minimalizacji zakłóceń, warto przyjrzeć się konkretnym zastosowaniom. W przemyśle gier komputerowych, gdzie czas reakcji ma kluczowe znaczenie, deweloperzy często stosują techniki buforowania oraz optymalizację kolejności operacji, aby zapewnić płynność działania gry. Przykładem może być gra AAA, która wykorzystuje wydajność GPU do renderowania skomplikowanych scen, jednocześnie dbając o to, aby CPU nie był obciążony zbędnymi operacjami.

W przypadku aplikacji naukowych, które wymagają intensywnych obliczeń, takich jak symulacje fizyczne czy analizy danych, minimalizacja zakłóceń ma kluczowe znaczenie dla uzyskania dokładnych wyników. Użycie technik profilowania oraz optymalizacji w takich aplikacjach pozwala na znaczące skrócenie czasu obliczeń, co może mieć bezpośredni wpływ na wyniki badań.

Sektor medyczny to kolejny obszar, gdzie precyzyjne profilowanie i minimalizacja zakłóceń mogą przynieść korzyści. W przypadku aplikacji przetwarzających obrazy medyczne, takich jak tomografia komputerowa, kluczowe jest, aby CPU mogło szybko analizować dane, podczas gdy GPU wykonuje złożone obliczenia renderujące. Odpowiednie dostosowanie architektury systemu oraz technik profilowania pozwala na uzyskanie lepszych wyników w krótszym czasie.

Przyszłość hybrydowych potoków CPU/GPU

Przyszłość hybrydowych potoków CPU/GPU wydaje się obiecująca, szczególnie w kontekście rozwoju sztucznej inteligencji i uczenia maszynowego. W miarę jak technologie te będą się rozwijać, a aplikacje będą wymagały coraz większej mocy obliczeniowej, znaczenie precyzyjnego profilowania obciążenia oraz minimalizacji zakłóceń będzie rosło. Właściwa architektura hybrydowych potoków stanie się kluczowym elementem, który wpłynie na wydajność i responsywność aplikacji.

Jednakże, rozwój technologii wiąże się również z nowymi wyzwaniami. Złożoność architektur obliczeniowych oraz rosnące wymagania dotyczące wydajności mogą prowadzić do sytuacji, w których zakłócenia będą trudniejsze do zminimalizowania. Dlatego tak ważne jest, aby branża nieustannie poszukiwała innowacyjnych rozwiązań, które pozwolą na lepsze zrozumienie interakcji między CPU a GPU.

Na koniec, warto pamiętać, że oprócz technik minimalizacji zakłóceń, kluczowe jest także odpowiednie przygotowanie aplikacji do pracy w hybrydowych potokach. Deweloperzy powinni być świadomi wyzwań związanych z asynchronicznymi operacjami DMA i stosować najlepsze praktyki, które pomogą w osiągnięciu optymalnej wydajności.

W obliczu rosnącej złożoności systemów obliczeniowych, precyzyjne profilowanie obciążenia w hybrydowych potokach CPU/GPU staje się nie tylko zaleceniem, ale wręcz koniecznością. Identyfikacja i minimalizacja zakłóceń międzyprocesorowych wywołanych przez asynchroniczne operacje DMA mogą znacząco poprawić wydajność aplikacji, co jest kluczowe w wielu branżach. W miarę jak technologie się rozwijają, konieczne będzie ciągłe doskonalenie strategii optymalizacji, aby sprostać rosnącym wymaganiom użytkowników.