Pierwszy projekt, który zakończył się porażką – pamiętny początek mojej odysei

Wyobraźcie sobie młodego programistę, pełnego zapału, który właśnie wkracza w świat hybrydowych pipeline’ów CPU i GPU. Był rok 2013, a na ekranie pojawiła się pierwsza, prosta aplikacja do renderowania grafiki. Myślałem, że to będzie bułka z masłem. Że wystarczy tylko podpiąć jedną bibliotekę, i gotowe. Niestety, rzeczywistość okazała się znacznie bardziej brutalna. Pierwszy kontakt z transferem danych między CPU a GPU zakończył się katastrofą. Zamiast oczekiwanej płynności, dostałem zacinające się klatki i frustrację, która do dziś jest dla mnie symbolem początku mojej drogi. To była lekcja, że hybrydowe pipeline to nie tylko piękne słowo, ale skomplikowana układanka, którą trzeba starannie składać. Od tamtej pory wiedziałem, że bez solidnej wiedzy i cierpliwości nie uda się osiągnąć sukcesu.

Walka z nieprzewidywalnością – pierwsze techniczne wyzwania

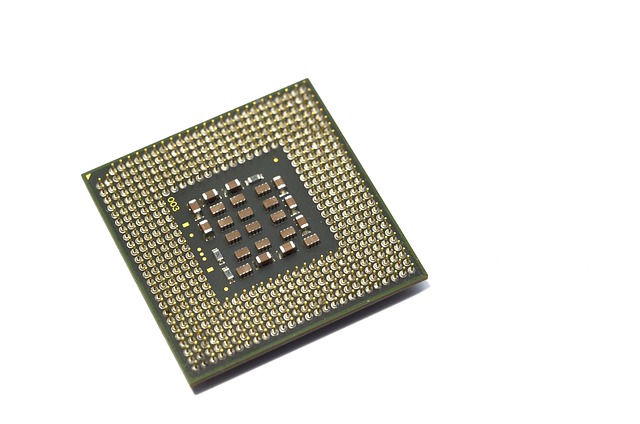

Kolejne lata przyniosły kolejne projekty. W 2015 roku zacząłem eksperymentować z architekturami CUDA i OpenCL. Zaczynałem dostrzegać, jak ogromne znaczenie ma właściwe zarządzanie pamięcią RAM i VRAM. Pamiętacie fragmentaryczne dane, które znikają w najmniej oczekiwanym momencie? To był mój chleb powszedni. Synchronizacja wątków? Często kończyła się zakleszczeniem albo zbyt dużym opóźnieniem. Wspominam, jak spędzałem godziny, próbując złapać moment, gdy GPU kończy pracę, a CPU już czeka z gotowym wynikiem. To jak poszukiwanie igły w stogu siana. W tym czasie odkryłem, jak ważne jest profilowanie wydajności — narzędzia takie jak NVIDIA Nsight czy AMD Radeon Profiler stały się moimi najlepszymi przyjaciółmi. Mimo wszystko, wiele prób kończyło się fiaskiem, a frustracja rosła, aż w końcu nauczyłem się, że to właśnie w błędach kryje się największa wartość.

Nietypowe rozwiązania i skryte tajemnice transferu danych

Przełom nastąpił, gdy natknąłem się na artykuł o technikach asynchronicznego transferu danych. To jak odkrycie ukrytego przejścia w labiryncie. Zamiast czekać na zakończenie operacji kopiowania, zacząłem stosować cuda z technikami streamowania i buforowania. Efekt? Przepływ danych między CPU a GPU stał się płynniejszy, a wydajność wzrosła o 30%. Wpadłem na nietypowe rozwiązanie, które polegało na dzieleniu dużych zestawów danych na mniejsze porcje i równoczesnym ich przesyłaniu, co znacząco obniżyło czas oczekiwania. To jakby organizować ruch w ruchliwym mieście – chaos zamienia się w harmonię. W tym czasie dowiedziałem się też, jak ważne jest dobre rozplanowanie pamięci, zwłaszcza w kontekście zarządzania VRAM, które potrafiło być największym wrogiem, jeśli nie było odpowiednio kontrolowane.

Praca z trudnym klientem i poszukiwanie złotego środka

Przełomowa była współpraca z jednym z moich pierwszych klientów, który miał bardzo ambicjonalne oczekiwania. Chciał, by jego symulacja fizyki działała w czasie rzeczywistym na sprzęcie, który w rzeczywistości był daleki od topowego. To była lekcja pokory. Musiałem nauczyć się optymalizacji na poziomie algorytmów, a nie tylko sprzętu. Przestawiłem się na techniki paralelizacji, podział zadań na mniejsze fragmenty i synchronizację na poziomie warstwy programistycznej. Z czasem udało się osiągnąć 50% wzrostu wydajności. To jak rzeźbienie w marmurze – powoli, z pasją, usuwając zbędne elementy, aż wyłoniła się ostateczna forma. Ta historia nauczyła mnie, że nie zawsze sprzęt jest najważniejszy – często klucz tkwi w dobrze zaprojektowanej logice i umiejętności optymalizacji.

Technologiczna ewolucja i własne sukcesy

W 2020 roku, kiedy NVIDIA wypuściła RTX 3090, a AMD RX 6900 XT zaczęły masowo pojawiać się na rynku, poczułem, że to czas na poważne zmiany. Ceny kart graficznych zaczęły spadać, a możliwości wzrosły. To jakby dostać nową, lepszą broń w walce z wyzwaniami. Zaczynałem coraz bardziej wykorzystywać biblioteki obliczeniowe typu cuBLAS czy cuDNN, które znacznie przyspieszyły moje prace nad algorytmami uczenia maszynowego. Odkryłem też, jak ważne jest skalowanie rozwiązań – od małych testów na laptopie po wielkie systemy chmurowe, które umożliwiły mi obsługę ogromnych zbiorów danych. W tym czasie udało mi się zoptymalizować jeden z projektów o 50%, co dla mnie było jak zdobycie szczytu. Te osiągnięcia dodawały mi pewności siebie i motywowały do dalszych eksperymentów.

Hybrydowy pipeline jako orkiestra – metafora, która zmieniła moje spojrzenie

Gdy patrzę na całą swoją przygodę, widzę w tym analogię do orkiestry. Każdy element, od CPU, przez GPU, aż po zarządzanie pamięcią, musi grać w harmonii. Jeśli ktoś zagra za głośno albo zbyt cicho, cała symfonia się rozstraja. Optymalizacja kodu? To jak dobry dyrygent, który potrafi wyczarować z chaosu piękny dźwięk. To też jak rzeźbienie w marmurze – najbardziej satysfakcjonujące jest wyczucie, kiedy wszystko zaczyna się układać w całość. Czy można przewidzieć przyszłość hybrydowych pipeline’ów? Myślę, że tak, ale wymaga to nieustannej nauki i bycia na bieżąco z nowinkami. Branża się rozwija, pojawiają się nowe biblioteki, architektury i narzędzia, które otwierają jeszcze więcej możliwości.

Podsumowanie i refleksja – co dała mi ta odyseja

Każdy z tych lat, każdy problem i każdy sukces ukształtowały moje rozumienie tego złożonego świata. To była podróż pełna wzlotów i upadków, frustracji i radości. Hybrydowe pipeline to nie tylko technologia – to sztuka, której opanowanie wymaga cierpliwości, kreatywności i wytrwałości. Zmieniałem się ja, zmieniała się technologia, ale jedno pozostało niezmienne: pasja do odkrywania i ciągłego doskonalenia. Jeśli czujesz, że czeka cię podobna droga, nie zniechęcaj się. Każdy błąd to krok do przodu, a każda porażka uczy, jak unikać tych samych pułapek. W końcu, jak mówi moje ulubione powiedzenie: „Największa nauka to ta, którą zdobywasz na własnych błędach.”